NVIDIA ha presentado una nueva IA que busca resolver las limitaciones de otros modelos cuando se trabaja con conversaciones largas. Conocida como Nemotron 3, esta familia de modelos utiliza una arquitectura híbrida que permite manejar contextos largos sin requerir mucho poder de cómputo. La compañía se ha inspirado en DeepSeek y otras IA que ofrecen un rendimiento notable con un consumo energético menor, aunque enfocada a los agentes.

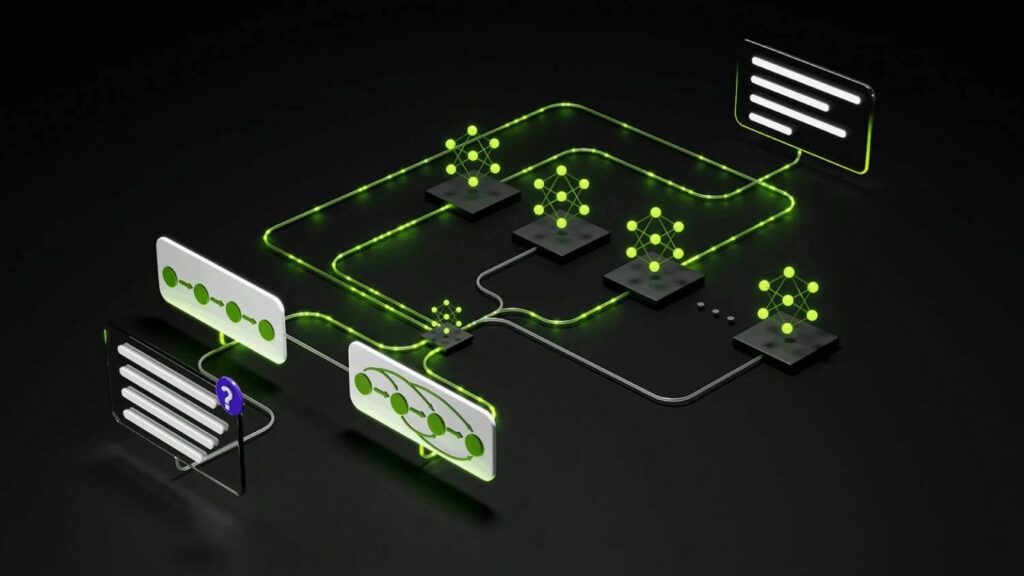

De acuerdo con una publicación en el blog de NVIDIA, la familia Nemotron 3 fue diseñada para construir una IA con capacidades autónomas. La nueva IA utiliza una arquitectura híbrida de Mamba-Transformer con MoE (Mixture of Experts), aprendizaje por refuerzo y una ventana de contexto nativa de un millón de tokens. En términos prácticos, esta mezcla de tecnologías le permite manejar secuencias largas con alta precisión en razonamiento sin sacrificar el consumo de memoria.

El uso de la arquitectura MoE, presente en modelos como DeepSeek-v4, permite que Nemotron active solo las partes necesarias para ejecutar una tarea específica. A diferencia de los modelos de IA convencionales, Mixture of Experts divide el modelo en componentes especializados (expertos) que optimizan el uso de recursos. NVIDIA menciona que su modelo activa subconjuntos de expertos por token, lo que se traduce en una reducción en costes de inferencia.

Esto último es importante si consideramos que la industria de IA atraviesa por una crisis que ya permea a otros sectores, como el de la telefonía móvil. La demanda de mayor poder de cómputo generó escasez de memorias de alto rendimiento, por lo que las empresas buscan alternativas para reducir el consumo sin sacrificar el rendimiento.

Nemotron 3: 1 millón de tokens de contexto para conversaciones largas

Una de las características más llamativas de Nemotron 3 es la ventana de contexto de hasta 1 millón de tokens. Esto le permite a un agente mantener una conversación prolongada reduciendo el riesgo de alucinaciones. La compañía señala que la IA puede procesar repositorios completos de GitHub y múltiples documentos en un solo búfer, así como también predecir tokens para reducir la latencia cuando se trabaja con cadenas de razonamiento largas.

Comparado con Nemotron 2 Nano, que utiliza arquitectura de transformer tradicional, Nemotron 3 consigue hasta 4 veces mayor rendimiento de tokens y reduce los costes de inferencia hasta en un 60%. “La arquitectura híbrida del transformador Mamba funciona varias veces más rápido con menos memoria, porque evita estas enormes estructuras de atención y cachés clave para cada token”, mencionó Kari Briski, vicepresidenta de software de IA generativa de NVIDIA en una entrevista con VentureBeat.

La nueva familia de modelos está conformada por Nemotron 3 Nano (30.000 millones de parámetros), Nemotron 3 Super (100.000 millones de parámetros) y Nemotron 3 Ultra (500.000 millones de parámetros). La variante Nano está enfocada en tareas específicas que requieren la máxima eficiencia, mientras que Super y Ultra están diseñadas para aplicaciones multiagente que involucren razonamiento de alta precisión.

¿Para quién está diseñada la IA de NVIDIA?

Si no has escuchado el nombre de Nemotron, no eres el único. A diferencia de ChatGPT, Gemini o Claude, la IA de NVIDIA no está dirigida a los usuarios finales, sino a los investigadores, empresas y desarrolladores. Nemotron 3 ya se está probando en compañías como Oracle, Accenture, Deloitte, Siemens y otras que buscan integrar agentes autónomos en los flujos de producción.

Otra característica que distingue a la familia es que los modelos son abiertos. Para Nemotron 3, NVIDIA liberó los conjuntos de datos, prompts de ejemplo y documentación, así como recetas detalladas de entrenamiento en su repositorio de GitHub. Nemotron 3 Nano está disponible a partir de hoy, mientras que las variantes Super y Ultra llegarán durante la primera mitad de 2026.